Топ UI-паттернов для работы с ИИ-агентами в 2026

В 2026 интерфейсы с ИИ-агентами эволюционировали от простых чатов к полноценным adaptive системам. Вот 10 ключевых паттернов, которые уже используют CopilotKit, Claude, Perplexity и другие. Краткий справочник по основным паттернам, которые определяют, как LLM участвует в интерфейсе и как пользователь взаимодействует с агентами — по разделам для каждого: роль LLM, сценарии применения, примеры и оценка зрелости на 2026 год.

1. Generative UI (GenUI)

LLM генерирует, выбирает или изменяет части интерфейса в runtime.

Когда использовать: когда интерфейс должен сильно адаптироваться под запрос пользователя.

Примеры: CopilotKit, AG-UI, Open-JSON-UI, A2UI, MCP Apps.

Уровень зрелости (2026): ★★★★★ (самый горячий тренд).

Generative UI (генеративный интерфейс) — это любой пользовательский интерфейс, который частично или полностью создаётся ИИ-агентом, а не исключительно дизайнерами и разработчиками. Вместо того чтобы интерфейс был заранее «нарисован» вручную, агент участвует в том, что появляется на экране, как структурирована информация и в некоторых случаях даже в том, как составлен layout.

Идея проста: по мере роста возможностей агентов UI агентного приложения сам становится динамическим выходом системы — способным адаптироваться, перестраиваться и реагировать на намерение пользователя и контекст приложения. Реализовать это можно очень по-разному, у каждого подхода свои компромиссы.

Далее в разделе:

- Application Surfaces — где Generative UI проявляется внутри агентного приложения.

- Attributes — чем отличаются типы и варианты использования GenUI и почему.

- Types — основные типы Generative UI, их применение и компромиссы.

- Ecosystem Mapping — как разные типы GenUI используются в экосистеме.

- AG-UI и CopilotKit — как AG-UI и CopilotKit работают с разными типами Generative UI.

Application Surfaces

Generative UI может появляться в разных частях приложения: в чате (карточки, кнопки, формы по запросу), в сайдбаре или панелях (динамические виджеты), в основном контенте (артефакты, превью) или в модальных окнах и тултипах. Выбор поверхности определяет, насколько «агентным» ощущается интерфейс. Ниже — три основных типа поверхностей.

1. Chat (Threaded Interaction)

Интерфейс в стиле Slack: диалог по очереди, приложение выступает посредником каждого хода. Generative UI появляется прямо в потоке сообщений — карточки, блоки, ответы инструментов.

Ключевые черты:

- Пошаговый, сообщение-за-сообщением поток.

- Приложение медиирует всё общение с агентом.

- Подходит для поддержки, Q&A, отладки и пошаговых сценариев.

Примеры: Slack-боты, Discord-боты, Intercom AI Agent, Zendesk AI, GitHub Copilot Chat, Notion AI Chat.

2. Chat+ (Co‑Creator Workspace)

Раскладка «рядом» или несколько панелей: в одной — чат, в другой — динамический canvas. Canvas становится общим рабочим пространством, где появляется и эволюционирует агентно-генерируемый UI.

Ключевые черты:

- Чат остаётся, но вторичен.

- В canvas отображаются структурированные выводы и превью.

- Generative UI может появляться и в canvas, и в чате.

- Идеально для создания, планирования, редактирования и многошаговых задач.

Примеры: Figma AI, Notion AI workspace, Google Workspace Duet side-panel, Replit Ghostwriter paired editor.

3. Chatless (Generative UI в нативном интерфейсе приложения)

Агент не общается с пользователем напрямую. Он общается с приложением через API, а приложение рендерит генеративный UI от агента как часть своего нативного интерфейса.

Ключевые черты:

- Чат-поверхности нет вообще.

- Приложение решает, когда и где показывать Generative UI.

- Воспринимается как встроенная функция продукта, а не как диалог.

- Идеально для дашбордов, подсказок и автономных помощников.

Примеры: Microsoft 365 Copilot (inline-редактирование), Linear Insights, Superhuman AI triage, HubSpot AI Assist, Datadog Notebooks AI panels.

Attributes

Вариации GenUI задаются атрибутами: кто инициирует генерацию (пользователь vs агент), насколько структурирован вывод (жёсткая схема vs свободная разметка), переиспользуемость (шаблоны vs полная генерация), степень доверия к агенту (подтверждение vs авто-применение). От этих атрибутов зависят UX и сложность реализации. Ниже — два важных атрибута.

Freedom of Expression (свобода представления)

Типы Generative UI сильно различаются тем, что они могут отображать — своей визуальной «свободой».

На фиксированном конце спектра статический GenUI возвращает только заранее заданные компоненты.

На противоположном конце open-ended UI может включать произвольный HTML, что в теории позволяет реализовать любой тип взаимодействия.

Декларативный UI занимает середину: более широкий, но всё ещё ограниченный визуальный словарь, из которого могут выбирать и программист, и агент.

Who has Control (кто контролирует представление)

Более тонкий и сложный в управлении атрибут — кто решает, как выглядит представление: агент (LLM) или программист (разработчик приложения).

На примере open-ended GenUI: агент может показывать произвольный HTML. Но откуда берётся этот HTML? Он может быть заранее описан в коде и лишь «возвращаться» агентом, или полностью генерироваться LLM. Часто разработчик хочет ограничить, что агент может показывать, чтобы UI ощущался нативным для приложения, даже если хочется использовать HTML ради богатства возможностей.

Даже со статическим GenUI остаётся выбор контроля: можно жёстко привязать агента к показу конкретного UI при определённом событии или позволить LLM самому выбирать и показывать его с нуля.

Types

Подходы к Generative UI делятся на три широкие категории — у каждой свои компромиссы в опыте разработчика, свободе UI, адаптивности и долгосрочной поддерживаемости.

| Тип | Описание |

|---|---|

| Static | UI выбирается из фиксированного набора заранее собранных компонентов. |

| Open‑Ended | Между агентом и фронтендом передаётся произвольный UI (HTML, iframes, свободный контент). |

| Declarative | Между агентом и фронтендом используется структурированная спецификация UI (карточки, списки, формы, виджеты). |

Как уже отмечено выше, типы различаются свободой/словарём представления UI, но любой из них может контролироваться программистом приложения или отдан на усмотрение агенту.

1. Static Generative UI

Статический GenUI позволяет разработчикам вручную создавать конкретные визуальные компоненты, а агент лишь решает, какие из них использовать. Агент не генерирует произвольный UI — он сопоставляет сгенерированные данные с существующими UI-компонентами.

В этой модели фронтенд задаёт все детали опыта: раскладки, стили, паттерны взаимодействия и ограничения. Бэкенд или агент поставляют информацию и намерение, а рендер в итоге идёт из заранее заданного набора компонентов.

Зачем используют:

- Гарантирует высокую визуальную полировку и консистентность.

- Идеально для высоконагруженных и критичных поверхностей, где важна предсказуемость.

Компромиссы:

- Чем больше сценариев — тем больше компонентов нужно разрабатывать и поддерживать.

- Кодовая база фронтенда растёт пропорционально числу возможностей агента.

Пример: CopilotChat с AG-UI — агент описывает инструменты, AG-UI обеспечивает связь, фронтенд рендерит заранее заданные компоненты (например, карточку погоды).

2. Open-Ended Generative UI

Open-ended GenUI — противоположный конец спектра. Агент генерирует целые UI-поверхности — часто в виде HTML, iframes или свободной разметки. Вместо выбора из готовых компонентов агент может вернуть целый UI-пакет, который фронтенд просто отображает.

Подход даёт максимальную гибкость представления: календарь, своя таблица, анимация, интерактивный HTML-виджет — либо сгенерированный LLM, либо заранее описанный разработчиком.

Зачем используют:

- Любой тип UI может быть частью ответа агента — задан программистом или сгенерирован агентом.

- Минимальная связность между фронтендом и поведением агента.

- Быстрое прототипирование и сложные сценарии без циклов доработки фронтенда.

Компромиссы:

- Вопросы безопасности и производительности при рендере произвольного контента.

- Обычно заточен под веб, сложнее переносить в нативные окружения.

- Консистентность стилей и соответствие бренду усложняются.

Пример: MCP-UI и ChatGPT Apps SDK — агент возвращает готовый HTML/iframes, которые рендерят произвольный UI (например, карта), давая максимальную гибкость.

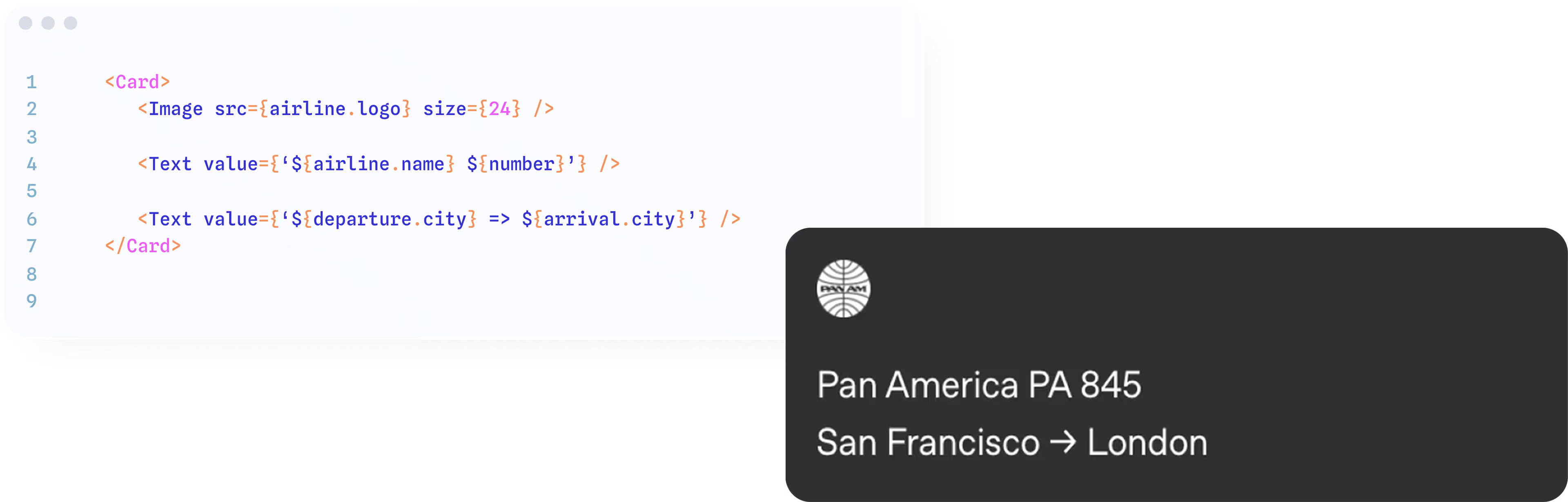

3. Declarative Generative UI

Декларативный GenUI балансирует структуру и гибкость: агент возвращает структурированную спецификацию, а не произвольный UI-код. Вместо свободного HTML агент выдаёт хорошо определённую схему — набор карточек, списков, форм или виджетов по декларативному стандарту.

Подход сохраняет консистентность и при этом даёт агенту гораздо большую выразительность, чем чисто статическая библиотека компонентов. Золотая середина: UI не собирается вручную под каждый кейс, но и не полностью свободный.

Зачем используют:

- Широкий охват сценариев без кастомных компонентов под каждый.

- Одна и та же спецификация может рендериться в разных фреймворках (React, мобильные, десктоп и т.д.).

- Чёткое разделение логики приложения и представления.

Компромиссы:

- Часть кастомных UI-паттернов может быть недоступна.

- Визуальные отличия возможны, если спецификация интерпретируется по-разному.

Пример: Open-JSON-UI — агент возвращает структурированную спецификацию (например, Card), фронтенд интерпретирует и рендерит её консистентно (например, карточка авиарейса).

Ecosystem Mapping

Несколько недавно анонсированных спецификаций Generative UI — MCP-UI, Open JSON UI и вышедший недавно A2UI — добавили разнообразия (и некоторой путаницы) в экосистему генеративных интерфейсов.

Стили GenUI хорошо ложатся на карту экосистемы инструментов и этих стандартов.

Важно: ни один подход не лучше другого по умолчанию — выбор зависит от приоритетов приложения, поверхностей и UX-философии.

| Подход | Примеры | Сильные стороны | Слабые стороны |

|---|---|---|---|

| Static | AG-UI, CopilotChat, useAgent | Точность, надёжность, контроль бренда | Трудозатратная разработка, линейный рост |

| Open-Ended | MCP-UI, ChatGPT Apps | Неограниченная креативность | Сложно стилизовать, обезопасить и портировать |

| Declarative | Open-JSON-UI, A2UI | Баланс, масштабируемость, мульти-рендерер | Ограниченная полная кастомизация |

AG-UI и CopilotKit

AG-UI и CopilotKit поддерживают разные типы Generative UI: от вставки готовых компонентов по ответу агента до генерации разметки (например, JSON/UI-описаний) и рендера динамических форм и карточек. Оба инструмента позволяют совмещать статический UI приложения с агентно-генерируемыми блоками и настраивать, где и как агент «рисует» интерфейс.

AG-UI задуман так, чтобы поддерживать весь спектр подходов к Generative UI и при этом добавлять общие возможности, которые их объединяют. AG-UI интегрируется со всеми типами: статическим, декларативным и open-ended GenUI. Независимо от того, предпочитает ли команда ручные компоненты, структурированные схемы или поверхности, созданные агентом, AG-UI поддерживает соответствующий workflow.

При этом AG-UI вводит общие примитивы — модели взаимодействия, синхронизацию контекста, обработку событий, общий фреймворк состояния — которые унифицируют то, как агенты и UI общаются во всех типах поверхностей.

CopilotKit работает с любым Generative UI и использует AG-UI для связи агента с фронтендом. В результате у разработчиков формируется единая ментальная модель, а агенты получают возможность использовать возможности любого паттерна GenUI.

2. Streaming + Thinking UI

Показываем «thinking», step-by-step reasoning, markdown и артефакты по мере генерации.

Когда использовать: во всех чат- и агент-интерфейсах.

Примеры: Vercel AI SDK, Stream UI, shadcn/ui + streaming. Ant Design X — React-библиотека для AI-интерфейсов с компонентами Think (процесс размышления), ThoughtChain (chain of thought) и стримингом Markdown. Подробнее: Ant Design Chat: UI-компоненты для чат-ботов и AI-агентов.

Уровень зрелости (2026): ★★★★★ (стандарт де-факто).

Streaming + Thinking UI (или «Thinking Steps UI», «step-by-step reasoning display») — один из самых зрелых и распространённых паттернов в 2026 году. Он решает главную проблему: пользователи не любят ждать «думания» агента в пустоте, а одна строка «Processing…» выглядит устаревше. Паттерн делает процесс прозрачным и вовлекающим: агент показывает промежуточные мысли, шаги, вызовы инструментов и частичные результаты в реальном времени, пока генерирует финальный ответ. Это повышает доверие, снижает отток и улучшает UX, особенно в сложных сценариях — анализ, планирование, многошаговые агенты.

| Компонент | Что показывает | Как выглядит в UI | Когда использовать | Примеры библиотек / хуков |

|---|---|---|---|---|

| Thinking Indicator | «Агент думает…» + анимация (spinner, dots) | Простой loader с текстом | Пока агент парсит запрос или планирует | shadcn/ui Skeleton, custom spinner |

| Streaming Text | Текст ответа по токенам (typewriter-эффект) | Буквы появляются постепенно | Основной ответ LLM | Vercel AI SDK useChat, streamText; CopilotKit streaming |

| Thinking Steps / Chain of Thought | Нумерованный или timeline-список шагов reasoning | «Шаг 1: Понимаю запрос…», «Шаг 2: Вызываю tool search…» | Multi-step reasoning (ReAct, o1-like, Reflection) | Custom <ThinkingSteps steps={array} /> компонент |

| Tool Call Logs | «Вызываю инструмент: web_search(query=…)» + результат | Карточки или collapsible-блоки с иконками tools | Когда агент использует инструменты | AG-UI events, LangGraph tool-logs streaming |

| Partial Artifacts | Промежуточные таблицы/код/графики во время генерации | Editable preview по мере стриминга | Генерация контента (код, отчёты, диаграммы) | Artifact viewer + streaming updates |

| Progress / Status | «Анализ 40%…», «Собираю данные…» | Прогресс-бар или timeline | Долгие задачи (multi-agent, RAG) | Progress component + state delta от AG-UI |

3. Hybrid Input (Text + GUI)

Пользователь пишет текст → LLM предлагает или добавляет кнопки, карточки, формы, календари.

Когда использовать: задачи с высокой интерактивностью — бронирование, редакторы, дашборды.

Примеры: CopilotKit, AG-UI, dynamic forms via JSON schema.

Уровень зрелости (2026): ★★★★☆.

Hybrid Input (Text + GUI) — один из самых практичных и быстрорастущих паттернов в 2026 году. Он решает проблему: чистый чат (только текст) часто слишком медленный и неудобный для задач, где нужны действия (фильтры, выбор даты, загрузка файлов, подтверждения), а чистый GUI (формы без контекста) — слишком жёсткий и не понимает естественный язык.

Hybrid Input = текст + графический интерфейс в одном потоке: пользователь пишет естественный запрос → LLM понимает intent → сразу предлагает/добавляет/вставляет GUI-элементы (кнопки, формы, календари, карты, карточки, слайдеры, drag-and-drop и т.д.) прямо в чат или рядом с ним. Интерфейс становится конверсационным и actionable одновременно.

Пример реализации в React/Next.js (CopilotKit / AG-UI стиль):

// Компонент чата с hybrid input

import { useCopilotAction } from "@copilotkit/react-core";

import { DatePicker } from "@/components/ui/date-picker"; // shadcn или custom

import { Button } from "@/components/ui/button";

function HybridChat() {

// Агент может вызвать action для показа GUI

useCopilotAction({

name: "suggestTravelDates",

description: "Предложить даты поездки и показать календарь",

parameters: [

{ name: "suggestedStart", type: "string", description: "Предлагаемая дата начала" },

{ name: "suggestedEnd", type: "string", description: "Предлагаемая дата конца" }

],

handler: async ({ suggestedStart, suggestedEnd }) => {

// Можно сохранить в state

},

render: ({ status, args }) => {

if (status === "executing") return <div>Генерируем варианты...</div>;

return (

<div className="hybrid-suggestion p-4 border rounded-lg bg-muted/50">

<p className="mb-2">Предлагаемые даты: {args.suggestedStart} — {args.suggestedEnd}</p>

<DatePicker

defaultValue={{ from: new Date(args.suggestedStart), to: new Date(args.suggestedEnd) }}

onChange={(range) => {

// Отправить уточнение обратно агенту

copilot.sendMessage(`Обновляю даты: ${range.from} — ${range.to}`);

}}

/>

<div className="mt-4 flex gap-2">

<Button variant="default">Подтвердить</Button>

<Button variant="outline">Изменить</Button>

</div>

</div>

);

}

});

// ... остальной чат-компонент

}4. Proactive / Predictive UI

LLM предугадывает следующий шаг и показывает варианты заранее.

Когда использовать: поиск, редакторы, планировщики, личные ассистенты.

Примеры: Context-aware suggestions, anticipatory design.

Уровень зрелости (2026): ★★★★☆.

Proactive / Predictive UI (проактивный / предиктивный интерфейс) — следующий уровень эволюции после Hybrid Input. В 2026 году это уже не просто «хайп», а реальный тренд в агентных приложениях: агент не ждёт явного запроса, а предугадывает следующий шаг пользователя на основе контекста, истории, поведения и текущего состояния задачи. Интерфейс становится «живым» и помогающим заранее, снижая когнитивную нагрузку и ускоряя достижение цели. Уровень зрелости ★★★★☆ — есть production-примеры (Superhuman, Linear Insights, HubSpot AI Assist, Microsoft 365 Copilot proactive nudges), но паттерн ещё не повсеместен, потому что требует сильного контекст-менеджмента и осторожности, чтобы не раздражать пользователя.

Что такое Proactive / Predictive UI в контексте LLM-агентов (2026)

LLM предугадывает следующий шаг и показывает варианты заранее (или даже выполняет микро-действия с подтверждением).

Ключ: агент анализирует:

- Текущий чат/задачу

- Историю взаимодействий

- Внешний контекст (время, устройство, предыдущие паттерны)

- Intent из последних токенов

Затем проактивно:

- Показывает подсказки и варианты

- Предлагает автодополнения и кнопки

- Автоматизирует рутину (с опцией отмены)

- Нотифицирует: «Я думаю, тебе нужно это…»

Это переход от реактивного («пользователь сказал → агент ответил») к проактивному («агент видит паттерн → предлагает/действует»).

Когда использовать (идеальные сценарии 2026)

- Поиск и исследования: во время чтения статьи агент предлагает «Углубить по теме X?» или показывает related cards заранее.

- Редакторы / кодинг: в Cursor, Claude Code — автодополнение не только кода, но и «Добавить тесты?» + кнопка «Сгенерировать».

- Планировщики / календари: пользователь пишет «встреча с командой на следующей неделе» → агент сразу показывает свободные слоты + кнопку «Забронировать».

- Личные ассистенты / CRM: в HubSpot, Superhuman — агент видит, что пользователь часто отвечает «Да, согласен» → предлагает шаблон ответа + кнопку отправки.

- Дашборды / аналитика: агент замечает тренд падения метрики → проактивно показывает alert + «Хочешь drill-down?» с готовым чартом.

5. Agent Progress / Canvas UI

Показываем этапы работы агента, дерево решений, canvas с объектами.

Когда использовать: сложные многошаговые задачи — анализ, генерация кода, планирование.

Примеры: Multi-agent threading, drag-and-drop canvas (как в LangGraph Studio).

Уровень зрелости (2026): ★★★★☆.

Agent Progress / Canvas UI (прогресс агента / канвас-интерфейс) — визуализация сложных процессов агента в реальном времени. В 2026 году паттерн стал must-have для multi-step, multi-agent и reasoning-heavy задач: пользователи хотят видеть не только результат, но и как именно агент дошёл до него — дерево решений, этапы, tool calls, loops, confidence levels, параллельные ветки. Это решает проблему «чёрного ящика»: повышает доверие, помогает в отладке, позволяет human-in-the-loop (прервать или отредактировать шаг) и делает интерфейс информативным и наглядным. Уровень зрелости ★★★★☆ — уже стандарт в инструментах вроде LangGraph Studio, Flowise, CopilotKit research canvas, но в custom-приложениях по-прежнему часто требует ручной реализации.

Ключевые варианты реализации Agent Progress / Canvas UI

| Вариант | Описание | GUI-элементы (как выглядит) | Когда использовать | Примеры инструментов / библиотек (2026) | Плюсы / Минусы |

|---|---|---|---|---|---|

| Graph / Tree Visualization | Дерево/граф узлов (nodes) и связей (edges), с цветами по статусу (success/warning/fail) | Узлы с иконками (tool call, reasoning, output), edges (primary/loop/alternate), progress bars | Multi-step reasoning, ReAct/Reflection, отладка агентов | LangGraph Studio (самый популярный), Mermaid + React, React Flow | ★★★★★ визуально мощно / требует backend streaming state |

| Timeline / Steps List | Вертикальный/горизонтальный timeline шагов с чекбоксами и деталями | Шаги как карточки: «Шаг 1: Parse Input ✓ 95%», collapsible details | Простые линейные workflows, чат-агенты с progress | Custom <AgentProgressTimeline steps={array} />, shadcn/ui Accordion | Просто реализовать / менее информативно для branching |

| Multi-Agent Threading / Tabs | Отдельные панели/вкладки для каждого агента в multi-agent системе | Tabs: «Research Agent», «Coder Agent», «Critic Agent» с собственным progress | Командная работа агентов (CrewAI-style, AutoGen) | CopilotKit multi-thread UI, AG-UI events per agent | Хорошо для коллаборации / может перегружать экран |

| Interactive Canvas | Бесконечный canvas с draggable nodes, где агент добавляет/обновляет карточки | Cards с текстом/кодом/чартами, arrows, real-time updates | Планирование, brainstorming, research canvas | CopilotKit + LangGraph canvas templates, Excalidraw-like + AI sync | Максимально engaging / сложнее в dev |

| Progress Dashboard | Sidebar или overlay с общим % progress, logs, confidence heatmap | Progress bar + mini-graph, collapsible logs | Долгие задачи (data analysis, code gen) | Vercel AI SDK + custom dashboard | Легко интегрировать / менее детализировано |

6. Editable Artifacts

LLM создаёт markdown, код, таблицу или диаграмму → пользователь может править прямо в UI.

Когда использовать: генерация контента, код, отчёты, дизайн-прототипы.

Примеры: Artifact pattern (Claude, Cursor, v0.dev style).

Уровень зрелости (2026): ★★★★☆.

Editable Artifacts (редактируемые артефакты) — один из самых пользовательских и «человечных» паттернов в стеке фронтенд–LLM 2026 года. Агент создаёт полноценный контент-объект (markdown-документ, код, таблицу, диаграмму, SVG, React-компонент, даже мини-приложение), который сразу отображается в UI как интерактивный и редактируемый элемент.

Пользователь может:

- Править текст/код прямо в панели

- Вносить изменения

- Просить агента доработать на основе правок

- Копировать, экспортировать, делиться

Это сильно отличается от обычного «выдал текст → копируй». Возникает human-in-the-loop цикл: агент генерирует → человек правит → агент улучшает → итерация в реальном времени.

Примеры из реальной жизни (2026)

- Claude Artifacts — классика: агент генерирует HTML/JS/React/SVG → слева чат, справа preview + редактируемый код. Пользователь пишет «измени цвет кнопки на синий» → Claude обновляет artifact вживую.

- Cursor AI — в IDE: генерирует и редактирует файлы проекта с AI-apply (diff + apply), плюс Composer для multi-file edits.

- v0.dev (Vercel) — генерирует React + Shadcn/Tailwind компоненты → preview + редактируемый код → копируй в свой проект или итерируй промптами.

- LibreChat и open-source альтернативы — артефакты для React/HTML/Mermaid-диаграмм прямо в чате.

Уровень зрелости ★★★★☆ — в Claude и v0 уже production, в custom-приложениях (CopilotKit, AG-UI) реализуется через streaming + editable previews.

Когда использовать Editable Artifacts

- Генерация контента: отчёты, документация, README, блог-посты

- Код-генерация: React-компоненты, скрипты, full pages

- Визуализации: таблицы (editable), Mermaid-диаграммы, charts

- Прототипы: мини-apps, дашборды, wireframes

- Дизайн/креатив: SVG-иконки, landing pages, email-шаблоны

Идеально для сценариев, где нужен быстрый итеративный цикл без копипаста в отдельный редактор.

7. Multi-Agent Threading / Tabs

Несколько агентов работают параллельно → каждая вкладка, блок или поток.

Когда использовать: командная работа агентов (исследование + дизайн + код).

Примеры: Thread UI, agent-specific panels.

Уровень зрелости (2026): ★★★☆☆.

Multi-Agent Threading / Tabs (многоагентные потоки / вкладки) — визуализация и управление параллельной работой нескольких агентов в одном интерфейсе. В 2026 году паттерн набирает обороты: single-agent системы часто упираются в лимиты контекста и скорости, а multi-agent (команды агентов) решают сложные задачи быстрее и надёжнее — например, исследование + дизайн + код + ревью одновременно.

Это паттерн для «командной работы» агентов: каждый специалист (Research Agent, Designer Agent, Coder Agent, Critic Agent) имеет свой «поток» или панель, где показывается его прогресс, выводы, tool calls. Пользователь видит всё в одном месте, может переключаться, вмешиваться или объединять результаты. Уровень зрелости ★★★☆☆ — в production-примерах (LangGraph Studio, CopilotKit open-multi-agent-canvas, CrewAI Studio dashboard, AutoGen Studio) уже есть, но в custom-приложениях требует ручной сборки (React tabs + streaming state per agent). Ещё не де-факто стандарт, но растёт быстро с трендом multi-agent orchestration (CrewAI, LangGraph, AutoGen, Google ADK).

Почему это важно в 2026

- Multi-agent системы выигрывают у single-agent в сложных задачах (параллелизм, специализация, critique loops) — исследования Anthropic/Google показывают +80–90% улучшения в reasoning-heavy задачах.

- Пользователь хочет видеть оркестрацию: кто что делает, где bottleneck, как агенты общаются.

- Решает проблему: один агент не тянет огромный контекст → разбиваем на роли → UI показывает threads/tabs для traceability.

- Связь с предыдущими паттернами: Agent Progress / Canvas UI — для одного агента, Multi-Agent Threading — для команды; Streaming + Thinking — per thread; Tool Result Cards — в каждом табе.

Ключевые подтипы Multi-Agent Threading / Tabs

| Подтип | Описание | GUI-элементы (как выглядит) | Когда использовать | Примеры инструментов / библиотек (2026) | Плюсы / Минусы |

|---|---|---|---|---|---|

| Tabs / Sidebar Panels | Каждый агент — отдельная вкладка или боковая панель с собственным чатом/progress | Tabs: «Researcher», «Coder», «Reviewer» с индикаторами активности | Командные workflows (content creation, research + synthesis) | CopilotKit multi-thread UI, CrewAI Studio dashboard, AutoGen Studio | Просто реализовать / экран может быть перегружен |

| Threaded Chat Streams | Один чат, но сообщения группируются по агентам (как Slack threads) | Threaded messages: @Researcher → ответ, @Coder → код | Conversational multi-agent (AutoGen-style debates) | Custom <AgentThread /> с grouping по agent_id | Компактно / сложнее отслеживать параллель |

| Split-Screen / Multi-Column | Экран делится на колонки: слева — input, справа — агенты в колонках | Columns: Agent 1 progress, Agent 2 output, Agent 3 critique | Параллельные независимые задачи (parallel execution) | Custom split layout, LangGraph Studio multi-view | Параллельный обзор / много места на экране |

| Agent-Specific Dashboard | Центральный дашборд с карточками/мини-панелями для каждого агента | Cards: «Research Agent: 60% done» + expand to full view | Monitoring long-running multi-agent jobs | LangGraph Studio multi-view, CrewAI Ops Platform | Обзорно / менее интерактивно |

| Dynamic Thread Spawning | Агенты спавнят sub-threads на лету (hierarchical) | Nested threads или accordion с sub-agents | Hierarchical delegation (lead agent → sub-agents) | LangGraph Deep Agents + CopilotKit canvas | Гибко / UI может стать хаотичным |

8. Invisible / Zero-UI

LLM работает в фоне, минимальный интерфейс — только nudge и уведомления.

Когда использовать: фоновые помощники, автозаполнение, смарт-коррекция.

Примеры: Background agents, proactive nudges.

Уровень зрелости (2026): ★★★☆☆.

Invisible / Zero-UI (невидимый / нулевой интерфейс) — крайняя степень «исчезновения» UI в пользу фоновой работы агента. В 2026 году это уже не фантастика, а реальный тренд в агентных системах: агент работает полностью или почти полностью в фоне — без чата, без экрана, без кнопок, только редкие nudges (лёгкие толчки/уведомления), когда это критично или полезно. Это противоположность Generative UI или Canvas: агент «невидим», как хороший дворецкий — делает всё сам, не отвлекает, но появляется, если нужно вмешательство. Уровень зрелости ★★★☆☆ — много концепций (Microsoft «Race to Zero UI», Humane AI Pin, Rabbit R1, ambient agents в смарт-домах и авто), но в production-приложениях пока осторожно из-за рисков over-automation, trust issues и privacy.

Почему Invisible / Zero-UI актуально в 2026

- Пользователи устали от уведомлений и чатов — хотят, чтобы AI «просто работал».

- Агенты стали надёжнее (лучше planning, reflection, tool use) — можно доверять фоновой работе.

- Тренд «ambient intelligence»: AI везде (wearables, автомобили, дома, уровень ОС), но невидим.

- Экономия когнитивной нагрузки: агент предугадывает и выполняет 80–90% рутины.

Примеры из жизни

- Microsoft Copilot / Entra ID agents — фоновые задачи в Office/Teams (авто-сортировка почты, проактивные подсказки без экрана).

- Superhuman / Linear — авто-ответы, triage, nudges только когда нужно.

- Health wearables / smart home — мониторинг, корректировки (температура, напоминания о лекарствах) без отдельного UI.

- Android Studio Agent Mode — фоновый код-фикс, только уведомление «изменения применены + undo».

- Humane AI Pin / Rabbit R1 — полностью screenless, только голос и nudges.

9. Tool Result Cards

Результаты вызова инструментов отображаются как богатые карточки.

Когда использовать: агенты, которые много работают с внешними API.

Примеры: Rich tool UI (как в Perplexity, Claude).

Уровень зрелости (2026): ★★★★☆.

Tool Result Cards (карточки результатов инструментов) — специализированный способ отображения выходов от внешних инструментов и API в агентных интерфейсах. В 2026 году паттерн стал стандартом для агентов, которые часто вызывают инструменты (web_search, code_execution, database queries, weather API, Stripe payments и т.д.), потому что сырой JSON или текст выглядит хаотично и неудобно.

Rich tool UI превращает сырые результаты в читаемые и интерактивные карточки — как в Perplexity (search results как карточки с источниками, графиками, snippets) или Claude (tool outputs в Artifacts или inline cards с collapsible деталями). Это повышает читаемость, доверие (пользователь видит источник и данные визуально) и позволяет взаимодействовать: копировать, expand, refine. Уровень зрелости ★★★★☆ — в Perplexity и Claude это уже core feature, в custom-агентах (CopilotKit, LangGraph UI, AG-UI) реализуется через declarative rendering или custom render functions.

Почему Tool Result Cards must-have в 2026

- Агенты с tool use (ReAct, function calling) часто возвращают структурированные данные (JSON, таблицы, списки, snippets, images).

- Пользователь не хочет копаться в raw output — хочет быстро понять суть и действовать.

- Улучшает UX: снижает cognitive load, повышает engagement (карточки кликабельны, expandable).

- Связь с предыдущими паттернами: Streaming + Thinking показывает процесс вызова, Tool Cards — результат; Editable Artifacts — если результат editable; Generative UI — карточки как компоненты.

Ключевые характеристики и примеры Tool Result Cards

| Характеристика | Как выглядит в UI | Примеры из реальных инструментов (2026) | Когда использовать | Плюсы / Риски |

|---|---|---|---|---|

| Rich Formatting | Карточка с заголовком, иконкой tool, colored status (success/error), collapsible body | Perplexity: search snippet cards с citations, images, graphs | Web search, news aggregation, API responses | ★★★★★ читаемо / перегрузка если слишком много |

| Interactive Elements | Кнопки «Copy», «Expand», «Refine with this data», links to source | Claude tool outputs: collapsible JSON/viewer + copy button | Code execution results, database queries | Actionable / security (не копировать sensitive data) |

| Visual Enhancements | Charts (от data), images (от image tools), tables (TanStack) | Perplexity Interactive Knowledge Cards: hover charts, stats cards | Data-heavy tools (finance API, analytics, weather) | Wow-factor / perf на мобильном |

| Error / Partial Handling | Red card с «Tool failed: retry?» + retry button | Perplexity/Claude: fallback cards «Partial results» | Unreliable APIs, rate limits | Graceful degradation / user frustration |

| Multi-Tool Aggregation | Несколько карточек в потоке (от parallel tool calls) | Multi-agent: одна карточка per agent/tool | Parallel tools, multi-agent systems | Organized / cluttered screen |

10. Feedback Loop UI

Пользователь оценивает, редактирует или уточняет ответ → LLM дообучается в рамках сессии.

Когда использовать: персонализация ответов, обучение на лету, уточнение предпочтений.

Примеры: Thumbs up/down, inline edit, follow-up prompts.

Уровень зрелости (2026): ★★★★☆.

Feedback Loop UI (интерфейс обратной связи / петля обратной связи) — завершающий элемент в серии фронтенд-паттернов для LLM-агентов 2026 года. Он превращает разовый ответ агента в непрерывный диалог улучшения: пользователь оценивает вывод, уточняет, правит, голосует — и агент сразу использует это для refine в рамках сессии (или для долгосрочного улучшения модели через RLHF-подобные механизмы). Паттерн делает агента адаптивным и обучаемым на лету, сильно повышая satisfaction и retention. Без него агент остаётся «одноразовым» — ответил и забыл. С ним — становится настоящим партнёром.

Уровень зрелости ★★★★☆ — в Claude (thumbs up/down + «Refine» / «Edit»), Perplexity (sources feedback + «Not helpful? Tell us why»), Cursor (apply/discard + feedback на suggestions), ChatGPT (thumbs + «Regenerate with changes») это уже core feature. В custom-приложениях (CopilotKit, AG-UI) реализуется через events + state updates.

Почему Feedback Loop UI критичен в 2026

- LLM всё ещё ошибаются (hallucinations, misinterpretation, incomplete reasoning) → нужна быстрая коррекция.

- Пользователи хотят контроль без перезапуска чата: «не то — уточни» → агент дорабатывает.

- Улучшает E-E-A-T и trust: видимая итерация показывает, что агент «учится» от пользователя.

- Связь с предыдущими паттернами:

- Streaming + Thinking → показывает процесс → feedback на шаги.

- Editable Artifacts → правки в артефакте → feedback на результат.

- Proactive UI → nudge «Это помогло?» → thumbs.

- Tool Result Cards → «Этот источник неверный?» → refine prompt.

Это human-in-the-loop в UI: пользователь даёт explicit/implicit сигналы → агент refine → цикл повторяется.

Подтипы Feedback Loop UI

| Подтип | Как работает UI + LLM | Элементы интерфейса | Когда использовать | Примеры из продуктов (2026) | Плюсы / Риски |

|---|---|---|---|---|---|

| Thumbs / Binary Feedback | Простой лайк/дизлайк после ответа | Thumbs up/down иконки в бабле ответа | Все чаты, быстрый сбор сигнала | ChatGPT, Claude, Perplexity | ★★★★★ просто / низкая информативность |

| Refine / Rewrite Buttons | Кнопки «Regenerate», «Make better», «Fix this» | Кнопки под ответом + optional dropdown причин | Когда ответ близок, но не идеален | Claude «Edit», Cursor «Refine», v0 «Regenerate» | Быстрый итератив / может loop’ить |

| Inline Editing + Feedback | Пользователь правит текст/код → агент видит изменения | Editable artifact + «Apply changes» → агент refine | Генерация контента/кода (Claude Artifacts style) | Claude Artifacts, Cursor Composer | Максимум точность / сложнее реализовать |

| Detailed Critique | После thumbs-down → LLM спрашивает «Что именно не так?» | Follow-up prompt в чате или modal с checkboxes/text | High-stakes ответы (отчёты, код, решения) | Perplexity «Why not helpful?», Claude critique mode | Богатые insights / friction для пользователя |

| Session-Level Learning | Feedback сохраняется в memory → влияет на весь чат | «Remember this preference» toggle или auto-apply | Долгие сессии (проекты, личные ассистенты) | Custom AG-UI state + CopilotKit readable context | Персонализация / privacy concerns |

Итого: самые распространённые и зрелые паттерны в 2026 — Generative UI и Streaming + Thinking UI. Остальные дополняют их в зависимости от типа продукта: чат, редактор, дашборд или фоновый ассистент.

Читай также

- Ant Design Chat: UI-компоненты для чат-ботов и AI-агентов — Think, ThoughtChain, streaming Markdown и парадигма RICH.

- ElevenLabs UI: компоненты для голосовых мультимодальных ИИ-агентов — Bar Visualizer, Transcript, Conversation и голосовые интерфейсы.

- System Design для Эпохи LLM. Часть 1 — архитектура, RAG, агенты и проектирование систем с LLM.